どうしたの?

最近の論文で人工知能が錯覚を覚えるようになったという論文が発表されました。

それでですね、偉そうにこんなこと言ってたもんで恥ずかしくなったのです悲報とか書いてますが人工知能の進化なんでみなさんにとっては快挙(それが人類にいい影響をもたらすかどうかは知らないけど)ですね。どんな錯覚が再現できたのか

これです実験の手法

技術的な詳細は論文の方を見てほしいのです。### 大まかにまず、人間の視覚には「短時間後の未来を予測する」というスペシャルな機能が備わっています(予測符号化)。先程の画像が回転する錯視はこの予測符号化という脳の特性によるものだと考えられています。だったら、「短時間後の未来を予測する」ように(人間の視覚と同じように)人間の世界の画像で訓練したネットワークに蛇の画像投げたら、回転した蛇の画像が帰ってくるのではないかという発想です。### ちょっと詳しくまずは[PredNet](https://coxlab.github.io/prednet/)という、今の画像を見せて次の画像を予測するための畳み込み再帰型NNをディズニーランドで遊ぶ人の1人称視点データセットで構築します。このデータセットは今の目的が人間の視覚を再現するネットワークを組むことなので、これでなくても人間の目に入ってくる日常的な画像だったら良いと思われます。準備としてはこれで良いのですが、わかりやすくするために回転をわかりやすく表示するために必要なギミックが少々加えられています(ここまで気になるなら論文見て)。結果

画像は引用します

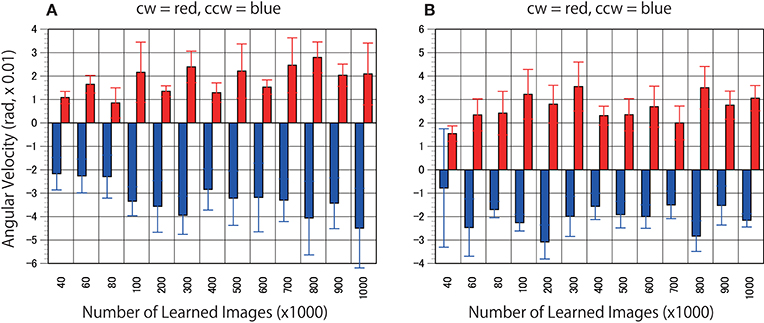

1 2

2 3

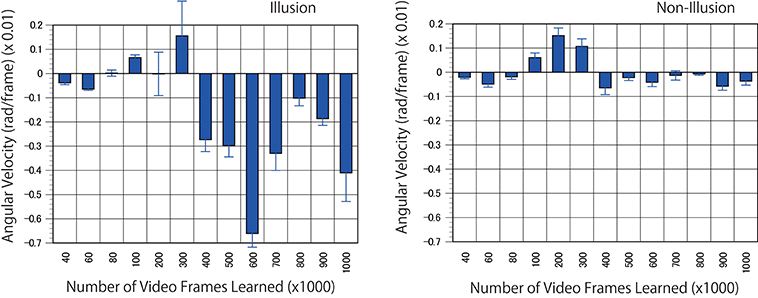

3 結果もざっくりと書きますので詳しく知りたい方は論文見てね!(てかもう皆見て。まずは、錯覚画像ではなくプロペラ画像で試します。つまり、止まっているプロペラの画像を与えて(1)、どっち側に回っているかをネットワークで判定するわけです。「いやいやそんなん人間だって分からんやん!w」その通りで、人間もわからないのでネットワークもどちらともの可能性を予測しています。(2)†そして最後に錯視画像を投げてみます(3)。結果は十分な数画像を学習すると学習枚数400K枚目くらいから反時計回りを判定するようになっているのが分かると思います。3の右側は錯視加工が施されていない画像です。回転が判定されていないのが分かると思います。

結果もざっくりと書きますので詳しく知りたい方は論文見てね!(てかもう皆見て。まずは、錯覚画像ではなくプロペラ画像で試します。つまり、止まっているプロペラの画像を与えて(1)、どっち側に回っているかをネットワークで判定するわけです。「いやいやそんなん人間だって分からんやん!w」その通りで、人間もわからないのでネットワークもどちらともの可能性を予測しています。(2)†そして最後に錯視画像を投げてみます(3)。結果は十分な数画像を学習すると学習枚数400K枚目くらいから反時計回りを判定するようになっているのが分かると思います。3の右側は錯視加工が施されていない画像です。回転が判定されていないのが分かると思います。まとめ

いや、恐ろしいですね。人間の視覚をNNで再現すれば錯視が再現できることが分かりました。勿論これでAGIが作れるようになったかといえばまだ先の話だとは思いますが、脳と人工知能の溝がひとつ埋まった気がしますね。人工知能、研究が盛んでヤバイので(彙 最新研究に目を光らせましょう!ノシ† cwとは時計回り、ccwとは反時計回りの略 ↩

𝖢𝗋𝖾𝖺𝗍𝗂𝗏𝖾 𝖦𝖯

𝖢𝗋𝖾𝖺𝗍𝗂𝗏𝖾 𝖦𝖯